强化学习—DDPG算法原理详解

一、 概述

在DQN中有讲过,DQN是一种 model free(无环境模型), off-policy(产生行为的策略和进行评估的策略不一样)的强化学习算法。DDPG (Deep Deterministic Policy Gradient)算法也是model free, off-policy的,且同样使用了深度神经网络用于函数近似。但与DQN不同的是,DQN只能解决离散且维度不高的action spaces的问题,这一点请回忆DQN的神经网络的输出。而DDPG可以解决连续动作空间问题。另外,DQN是value based方法,即只有一个值函数网络,而DDPG是actor-critic方法,即既有值函数网络(critic),又有策略网络(actor)。

DDPG算法原文链接: DDPG

二、算法原理

强化学习—DQN算法原理详解

一、 概述

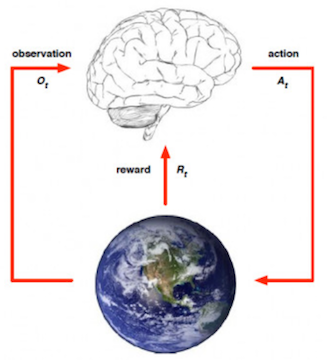

强化学习算法可以分为三大类:value based, policy based 和 actor critic。常见的是以DQN为代表的value based算法,这种算法中只有一个值函数网络,没有policy网络,以及以DDPG,TRPO为代表的actor-critic算法,这种算法中既有值函数网络,又有policy网络。

说到DQN中有值函数网络,这里简单介绍一下强化学习中的一个概念,叫值函数近似。在基本概念这篇中有讲过,一个state action pair \((s, a)\)对应一个值函数\(Q(s, a)\)。理论上对于任意的\((s, a)\)我们都可以由公式求出它的值函数,即用一个查询表lookup table来表示值函数。但是当state或action的个数过多时,分别去求每一个值函数会很慢。因此我们用函数近似的方式去估计值函数: \[\hat{Q}(s, a, w) \approx Q_\pi(s, a)\]